Technique SEO

Vous êtes administrateur d’un site internet et souhaitez optimiser votre SEO ? Vous devrez commencer par réaliser un diagnostic précis des éléments à travailler sur votre site pour améliorer votre positionnement sur les moteurs de recherche. Pour ce faire, vous avez tout intérêt à utiliser un crawler SEO, c’est-à-dire un logiciel qui va simuler le comportement des robots d’indexation de Google. Découvrez tout ce que vous devez savoir sur le fonctionnement du crawl.

Le fonctionnement d’un crawler

Avant de présenter le principe d’un crawler, il convient de rappeler le fonctionnement des moteurs de recherche tels que Google ou Bing. Pour classer les différents sites dans les résultats de recherche sur une requête donnée, ces moteurs utilisent des programmes informatiques dont la mission est de parcourir le web. Chez Google, ces robots d’indexation sont par exemple connus sous le nom de Googlebot.

Les robots des moteurs de recherche entrent ainsi sur un site et le visitent en suivant les différents liens qu’ils rencontrent sur leur chemin. Ils récupèrent au passage de précieuses informations sur chaque site, ensuite mixées dans un puissant algorithme pour finalement produire les SERP (search engine result page, ou page de résultats des moteurs de recherche).

Un crawler fonctionne de manière identique, à la seule différence qu’il ne provient pas d’un moteur de recherche tel que Google. Il s’agit en effet d’un programme informatique commandé par un éditeur de site web ou une agence SEO pour simuler et reproduire automatiquement le comportement des robots d’indexation de Google. En visitant votre site internet, le robot de crawl pourra ainsi réaliser un diagnostic précis des points à améliorer pour optimiser votre référencement naturel.

Le fait de crawler votre site vous donnera accès à une mine d’informations, notamment sur les erreurs à corriger pour améliorer votre positionnement dans les SERP (erreurs 404, poids d’une page, nombre de liens entrants et sortants, balises TITLE, etc.).

Vous souhaitez réaliser un crawl de votre site internet pour effectuer des optimisations SEO ? contactez-nous

Quels sont les différents robots de crawl ?

Il est possible de rencontrer trois types de robots crawler.

Le premier est celui utilisé par Google et les autres moteurs de recherche du marché. Il s’agit du crawler d’indexation. Comme évoqué précédemment, ce programme informatique a pour objectif de parcourir le web pour collecter des informations sur les différents sites web. Le but final du crawler d’indexation est de collecter suffisamment de données pour permettre au moteur de classer efficacement les résultats de recherche lors d’une requête d’un utilisateur.

Le nombre de pages parcourues par un robot d’indexation est connu sous le nom de budget de crawl. Cette donnée varie d’un site web à un autre en fonction de son nombre total de pages ou de son état de santé général. Pour connaître votre budget de crawl, il vous suffit de consulter la Google Search Console.

Le deuxième est le crawler de diagnostic. C’est celui qui est utilisé par les propriétaires de sites web ou professionnels du SEO pour aider à améliorer le référencement naturel. Notez que ce type de programme peut également permettre d’analyser les performances de sites tiers comme ceux de vos concurrents.

Enfin, le dernier crawler est dit de veille. Il présente notamment l’avantage de pouvoir réaliser un suivi précis de la politique de prix de sites concurrents. Il est par conséquent plutôt destiné aux sites e-commerce désireux de suivre attentivement l’évolution de leur marché.

Pourquoi utiliser le crawl dans le cadre d’une stratégie SEO ?

Dans le cadre de la mise en place ou de l’optimisation de votre stratégie SEO, l’utilisation d’un crawler de diagnostic est donc d’une importance capitale. Il va vous permettre de réaliser un audit SEO complet et d’identifier précisément les éléments de votre site web qui doivent être améliorés pour plaire aux robots de Google lors de leurs passages. Vous pourrez par conséquent gagner des places dans les SERP sur des mots-clés bien ciblés.

Concrètement, le robot de crawl va se concentrer sur les trois fondements majeurs du référencement naturel, à savoir la structure technique de votre site, la pertinence du contenu mis en ligne et l’efficacité de votre stratégie de backlinks (liens retour).

Le maillage interne

Dans un premier temps, un crawler va vous informer sur la qualité de votre maillage interne. Ce dernier désigne simplement la structure de votre site au travers de la manière dont sont organisés vos liens internes. Plus votre site possède de pages, plus il est probable que votre maillage interne soit complexe. Ce constat se vérifie notamment pour les sites e-commerce qui possèdent des milliers de fiches produits et d’innombrables catégories et sous-catégories.

Par exemple, les erreurs 404 apparaissent lorsqu’un lien renvoie vers une page en réalité inexistante. La présence d’erreurs 404 est bien entendu sanctionnée par Google. Le fait de crawler votre site web va donc vous permettre de les déceler et de les corriger.

Un maillage interne bien pensé présente ainsi l’avantage d’offrir à vos visiteurs une expérience d’utilisation simple et fluide. Naturellement, c’est également un aspect fortement apprécié par Google lorsque ses robots visitent vos pages de lien en lien. Concevoir un maillage interne efficace permet en effet de maîtriser également le parcours proposé aux robots d’indexation des moteurs de recherche.

Le contenu dupliqué

De même, un crawler de diagnostic a la capacité d’identifier le contenu dupliqué (ou duplicate content). Il s’agit concrètement de pages dont le contenu est identique, ou suffisamment proche pour créer de la confusion chez les robots de Google. Ces pages sont alors considérées comme des doublons et sont fortement pénalisées par les moteurs de recherche.

Grâce au crawler, vous pourrez corriger vos contenus dupliqués pour obtenir un meilleur positionnement dans les résultats de recherche.

Le netlinking

Votre stratégie de netlinking va également être analysée par les robots de Google. Un backlink est un lien placé sur un site web tiers et pointant vers l’une de vos pages. Pour les moteurs de recherche, la présence de liens retours est un indicateur de la popularité d’un site. Il convient toutefois de privilégier la qualité à la quantité, sous peine de voir vos efforts réduits à néant. En d’autres termes, les backlinks qui retiennent l’attention de Google sont ceux positionnés sur des sites tiers de qualité et faisant autorité dans leur domaine d’activité.

Le fait d’utiliser un crawler externe va ainsi vous permettre d’identifier les sites qui font des liens vers vos pages, ainsi que les ancres de liens qui sont utilisées, et d’ajuster en conséquence votre stratégie de netlinking.

Les meilleures solutions pour crawler un site internet

De nombreux crawlers existent pour vous permettre de simuler le passage d’un bot sur votre site et de réaliser un état des lieux précis de vos performances techniques en référencement naturel.

Screaming Frog : la référence SEO

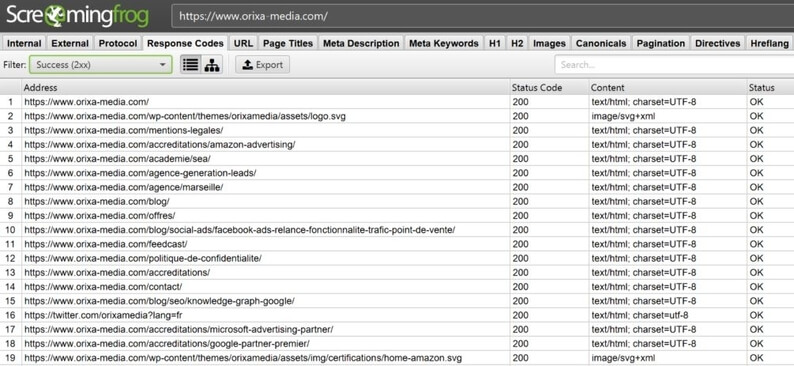

Gratuit jusqu’à 500 analyses, Screaming Frog SEO Spider est très utilisé par les professionnels du SEO. Ce logiciel complet parcours et extrait les éléments principaux d’un site web à partir d’une URL donnée. Parmi les principaux éléments rapportés par l’outil, on retrouve par exemple les balises title et les titres h1, les redirections 301 ou 302, les erreurs 404 ou 500, les meta descriptions ou bien encore le poids des images et les attributs ALT.

Exemple de l’interface du crawler ScreamingFrog

Autres Crawlers

OnCrawl propose des fonctionnalités également très intéressantes pour analyser les résultats de votre crawl SEO. Cette solution vous propose également de réaliser une analyse de logs, et d’intégrer divers outils tiers tels que Google Analytics, ou la Search Console de Google, afin de réaliser des analyses croisées.

NetPeak Spider est également un crawler SEO capable de vous livrer un fichier PDF contenant toutes vos problématiques de référencement triées par ordre d’importance. Celui-ci est disponible en langue anglaise.

Botify effectue quant à lui un scan complet de votre site afin d’obtenir l’ensemble des informations pertinentes d’un point de vue SEO. Il présente l’avantage d’intégrer une analyse de logs (fichiers journaux du serveur à partir desquels nous allons pouvoir comprendre comment Google perçoit votre site web) à ses fonctionnalités et de présenter les données obtenues de manière très visuelle, avec notamment la présence de graphiques. Côté tarif en revanche, Botify est assez onéreux.9

Enfin, SEMRush est un outil bien connu et assez complet, utilisé notamment pour la recherche de nouveau mots-clés et l’analyse de la visibilité d’un site sur internet. Vous pouvez également l’utiliser pour réaliser un audit SEO de manière assez succincte.

Les outils gratuits

Du côté des outils accessibles gratuitement, vous pouvez télécharger Xenu ou LinkExaminer. Le premier vous donnera notamment la possibilité d’identifier les liens brisés pour les corriger et d’accéder à un ensemble d’informations pertinentes (longueur des titres, poids des images, etc.). De son côté, LinkExaminer parcourt l’ensemble des liens d’une page HTML pour déceler d’éventuelles anomalies. Cette solution intègre également une fonctionnalité de détection du duplicate content.

Pour conclure, les crawlers sont de précieux alliés pour tous les administrateurs de sites web et experts en marketing digital. Outre le fait de mettre en place une veille concurrentielle, ils vous permettront surtout de connaître en temps réel l’état de santé général de votre site en termes de SEO. Suite à ces audits réguliers, vous pourrez ainsi ajuster les différents éléments (contenus, maillage interne, netlinking, meta-tags, sitemap, etc.) pour améliorer efficacement votre référencement naturel et générer plus de trafic sur vos pages.

Vous avez besoin d’aide pour réaliser un audit technique complet de votre site web ? N’hésitez pas à prendre contact avec notre agence SEO.